En los cálculos de Inteligencia Artificial (IA), tanto los microprocesadores convencionales como los gráficos están llegando a sus límites. Por ello, empresas e investigadores de todo el mundo trabajan en nuevas soluciones que brinden más eficiencia y eficacia. Algunos de ellos son los chips en formato de oblea y los ordenadores ópticos, pero en no mucho tiempo, estos podrían complementarse con un ordenador cuántico para cálculos especialmente exigentes.

En los tiempos que corren, cada vez son más las funciones asumidas por la IA, sobre todo en el sector automotriz con el auge del coche electrificado, conectado y en camino de la conducción autónoma. Por tanto, se hace imprescindible un hardware realmente potente y veloz para los complejos cálculos implicados en la gestión de los datos. Al fin y al cabo, en el futuro, solo con ordenadores de alto rendimiento será posible introducir nuevas funciones en la producción en serie, de acuerdo con el Dr. Joachim Schaper, director de IA y Big Data en Porsche Engineering.

“Los algoritmos aprenden a partir de multitud de situaciones captadas en el tráfico real por los vehículos de prueba, mediante cámaras, radares u otros sensores”, dice. “Los centros de datos son cada vez más incapaces de hacer frente a la creciente demanda. Ahora se necesitan días para entrenar una sola variante de una única red neuronal”. Así que, en su opinión, una cosa está clara: los fabricantes de coches necesitan nuevas tecnologías dedicadas a la IA que ayuden a los algoritmos a aprender mucho más rápido.

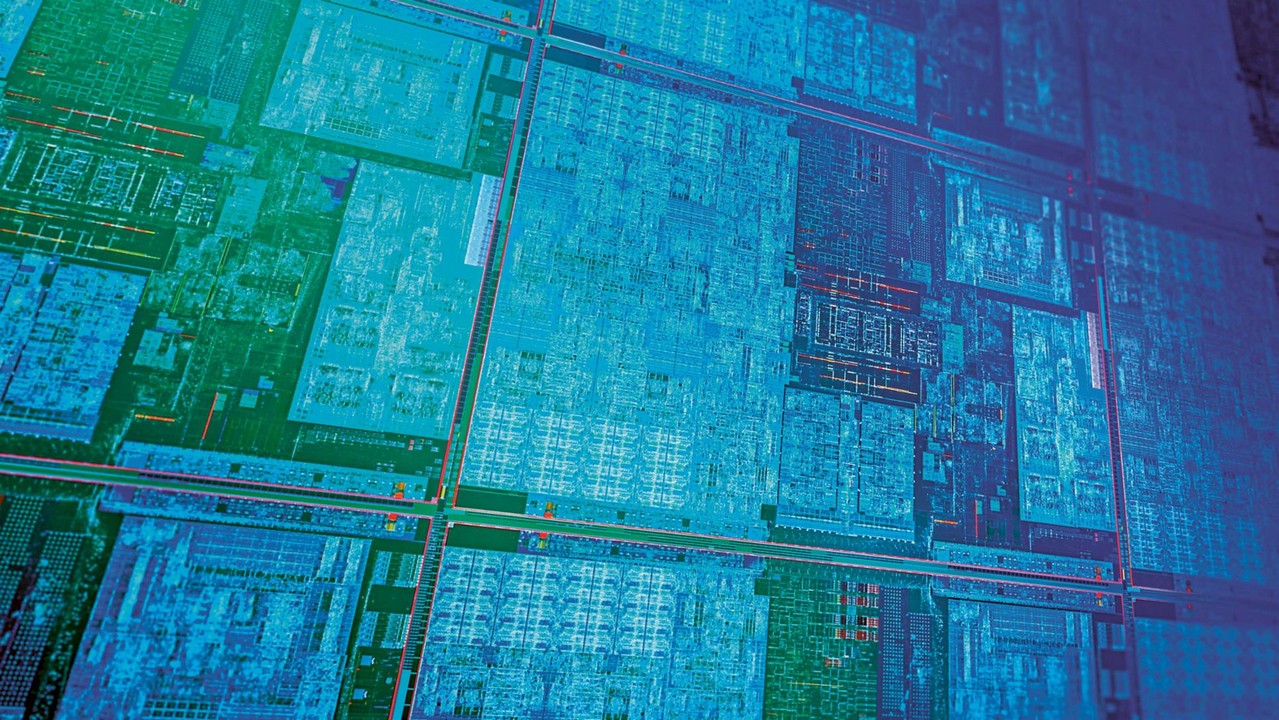

Para lograrlo, es necesario ejecutar en paralelo el mayor número posible de multiplicaciones vectoriales en las redes neuronales profundas (DNN), una tarea en la que están especializadas las unidades de procesamiento gráfico (GPU). De hecho, gracias a su sorprendente desarrollo durante los últimos años hemos podido disfrutar de grandes avances en la tecnología de IA. Sin embargo, las tarjetas gráficas no se diseñaron originalmente para su aplicación en la IA, sino para procesar las imágenes de la forma más eficiente posible.

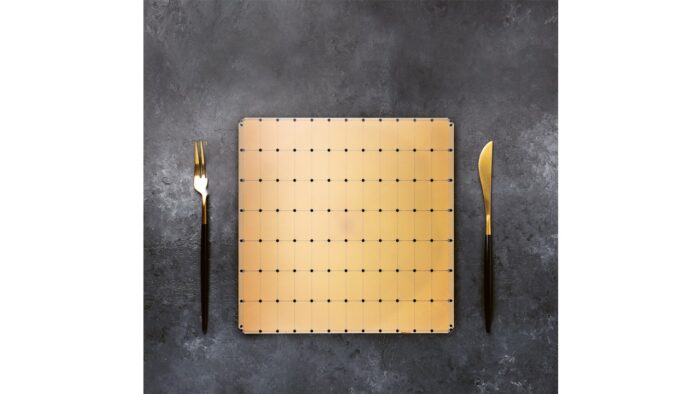

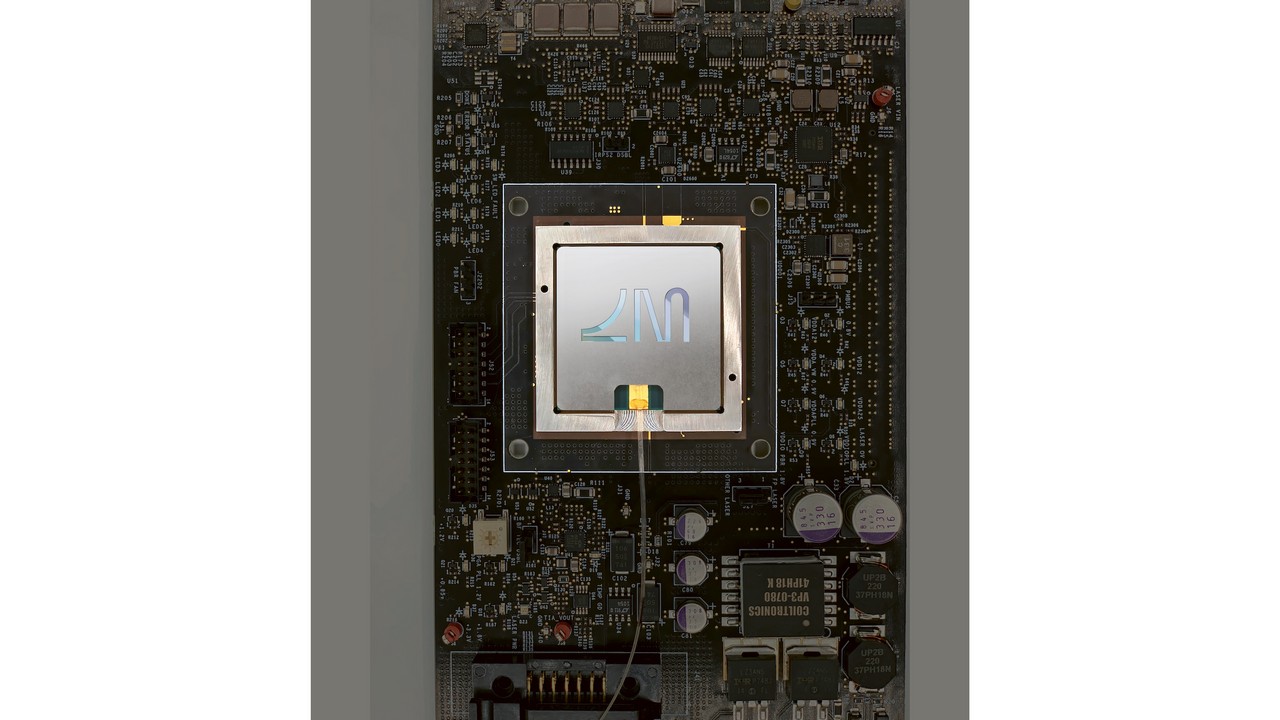

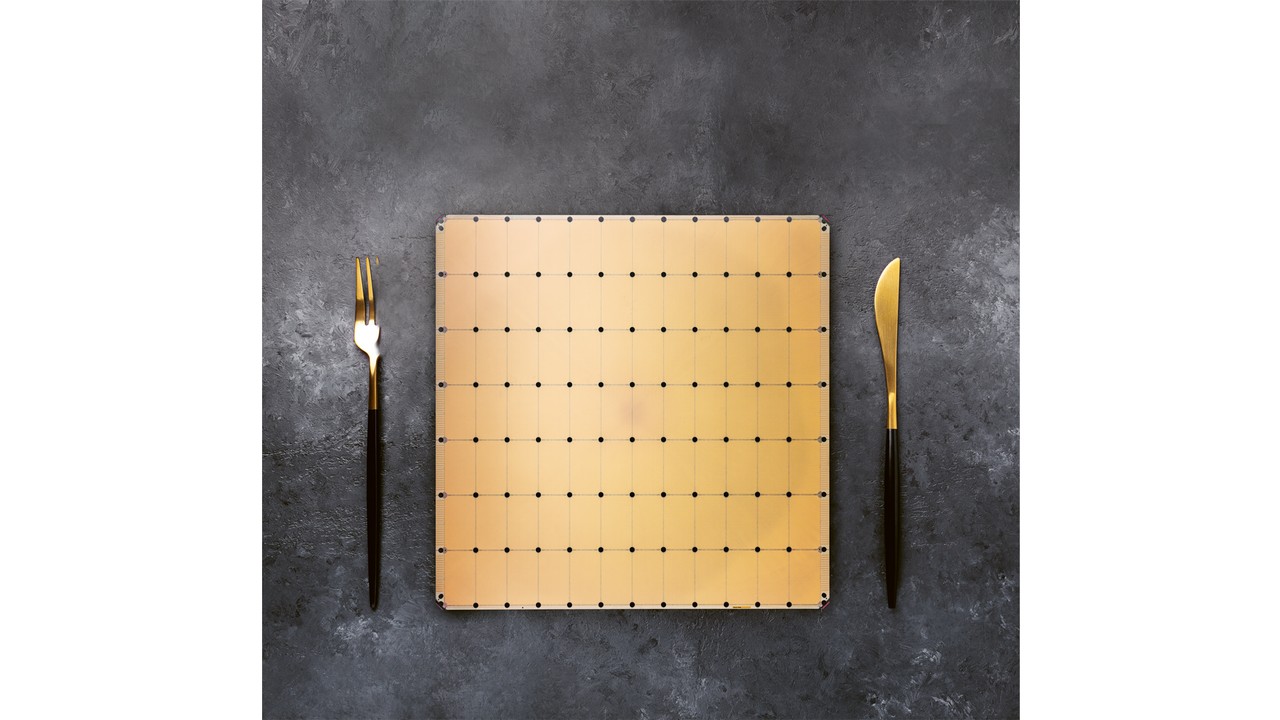

Actualmente, por muy buenas que sean estos microprocesadores, se quedan un tanto cortas si se trata de entrenar algoritmos a coches autónomos. Por tanto, hace falta hardware específico para hacer esos cálculos. En ese aspecto, empresas como Cerebras ha presentado una posible solución. La entidad californiana ha desarrollado el Wafer Scale Engine (WSE), y se adapta de forma óptima a los requisitos de las redes neuronales al combinar una enorme potencia de cálculo en un chip informático bastante grande en dimensiones.

Para ser exactos, es más de 50 veces mayor que un procesador gráfico normal y ofrece espacio para 850.000 núcleos de computación, 100 veces más que en una GPU actual de primer nivel. Además, los ingenieros de Cerebras han conectado en red los núcleos de cálculo con líneas de datos de gran ancho de banda. Según la entidad, la red del Wafer Scale Engine transporta 220 petabits por segundo (1.000.000 GB/s). Asimismo, se ha ampliado el cuello de la botella dentro de las GPU: 20 petabytes por segundo, 10.000 veces más que una GPU de alto rendimiento.

Como en nuestra cabeza, las neuronas de este cerebro artificial solo funcionan cuando reciben señales de otras neuronas. Las numerosas conexiones que están inactivas en ese momento no consumen recursos. En cambio, en las DNN, la multiplicación de la matriz vectorial implica a menudo multiplicar por el número cero. Esto cuesta tiempo innecesario, por lo que el Wafer Scale Engine evita hacerlo. “Se filtran todos los ceros”, dice Cerebras en su libro sobre el WSE. Así, el procesador solo ejecuta operaciones con un resultado distinto de cero.

Lógicamente, no está exento de algunos inconvenientes. Entre ellos encontramos su elevada demanda de energía eléctrica, de hasta 23 kW, y que requiere refrigeración por agua, razón por la que Cerebras ha desarrollado su propia carcasa para usarlo en algunos centros de datos. El experto en IA, Joachim Schaper, cree que el gigante procesador californiano también podría acelerar el desarrollo del automóvil. “Teóricamente, con el Wafer Scale Engine, una semana de aprendizaje podría reducirse a solo unas pocas horas”, estima. “Sin embargo, la tecnología aún tiene que demostrarlo en pruebas empíricas”.

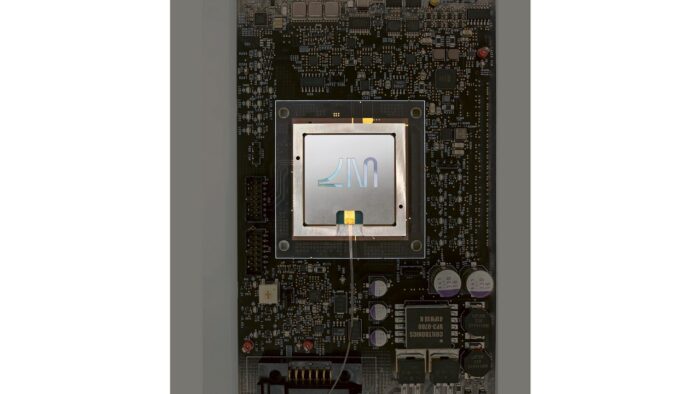

Ahora bien, por muy inusual que sea este nuevo procesador también funciona con transistores convencionales. En lugar de la electrónica, comparativamente lenta, hay quienes apuestan por un medio mucho más rápido para los cálculos de IA: la luz. Por eso hay una pareja de empresas estadounidenses, Lightelligence y Lightmatter, que están desarrollando procesadores ópticos. Así, las DNN podrían funcionar “varios cientos de veces más rápido que las electrónicas”, dicen los desarrolladores de Lightelligence.

Basándonos en el fenómeno de la interferencia, cuando las ondas de luz se amplifican o anulan entre sí, forman un patrón de luz-oscuridad. Si se dirige dicha interferencia de una manera determinada, el nuevo patrón corresponde a la multiplicación vectorial del patrón anterior. Así que las ondas de luz pueden “hacer matemáticas”. Para hacerlo funcional, los desarrolladores de Boston grabaron diminutas guías de luz en un chip de silicio. Como en un tejido, se cruzan varias veces, generando interferencias. Entre medias, unos diminutos elementos calefactores regulan el índice de refracción permitiendo controlar la interferencia.

Todo se gestiona con ordenadores de luz equipados con entrañas electrónicas convencionales que almacenan datos y hacen los cálculos, excepto las multiplicaciones vectoriales matriciales. Entre ellos se encuentran, por ejemplo, las funciones de activación no lineal que modifican los valores de salida de cada neurona antes de pasar a la siguiente capa. Combinado la computación óptica y la digital, las DNN pueden calcular con extrema rapidez. “Su principal ventaja es la baja latencia”, explica Lindsey Hunt, portavoz de Lightelligence.

Esto permite, por ejemplo, que la DNN detecte más rápidamente los sujetos en las imágenes, como peatones, ciclistas u otros objetos. En el ámbito de la circulación autónoma, esto podría significar reacciones más rápidas ante las situaciones críticas. “Además, el sistema óptico toma más decisiones por vatio de energía eléctrica”, afirma Hunt. Esto es especialmente importante, ya que el aumento de la potencia en el cálculo en los automóviles se produce cada vez más a expensas del ahorro de combustible y la autonomía.

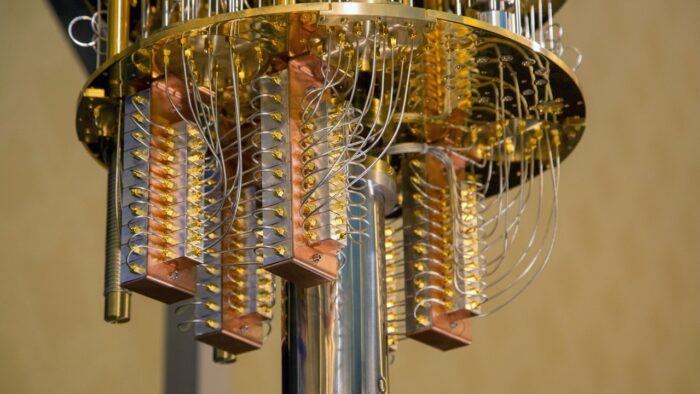

Pero, ¿cómo funciona un ordenador cuántico? Ciertamente, aún están algo lejos de verse en una aplicación práctica, pero es seguro decir que acelerarán los cálculos de la IA porque pueden procesar grandes cantidades de datos en paralelo. Para ello, trabajan con los llamados “qubits”. A diferencia de la unidad clásica de información, el bit, un qubit puede representar los dos valores binarios 0 y 1 simultáneamente. Los dos números coexisten en un estado de superposición que solo es posible en la mecánica cuántica.

“Cuanto más complicados son los patrones, más difícil es para los ordenadores convencionales distinguir las clases”, explica Heike Riel, que dirige la investigación cuántica de IBM en Europa y África. Esto se debe a que, con cada dimensión, resulta más costoso calcular la similitud de dos objetos: ¿Cuánto se parece una persona que cruza la calle en una silla de ruedas eléctrica o en un andador? En comparación con los ordenadores convencionales, los ordenadores cuánticospueden trabajar eficazmente en todos los espacios de grandes dimensiones.

En un futuro previsible, se debería poder demostrar la superioridad del ordenador cuántico en determinadas aplicaciones, es decir, resuelven los problemas con mayor rapidez, eficacia y precisión que un ordenador convencional. Pero la construcción de un ordenador cuántico potente, con corrección de errores y de uso general todavía llevará algún tiempo. Los expertos calculan que tardará al menos otros 10 años, pero, aún así, la espera podría merecer la pena. Al igual que los procesadores ópticos, los ordenadores cuánticos son clave en la movilidad del futuro.

Fuente: Porsche

Galería de fotos:

2/6Fotos

2/6Fotos