Los coches autónomos son el futuro, poco a poco se van introduciendo a pesar de la reticencia del ser humano. Esta tecnología, diseñada para no cometer errores, tiene sus aspectos positivos y negativos de ahí que los diseñadores pretenden avanzar para terminar de un plumazo con los contras. Uno de los últimos pasos que se han dado llegó de la mano de la NHTSA, organismo que ha declarado la Inteligencia Artificial como humana. Ahora, los filósofos toman el mando para diseñar el coche basándose en los dilemas éticos que le puedan surgir en la carretera. ¿Te imaginas a Platón o Kant tomando decisiones al volante?

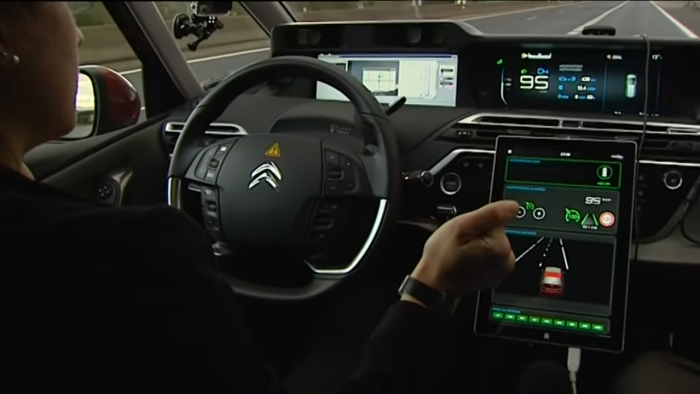

Los fabricantes caminan por el sendero de la investigación en cuanto a dirección, aceleración, frenado, sensores detectores de peatones y ciclistas se trata, pero ¿qué sucede si un coche tiene el mando y no sabe a quién darle prioridad ante un problema? Lo que lleva también a preguntarse, ¿cuál es la responsabilidad del vehículo autónomo?

Chris Gerdes, profesor de la Universidad de Stanford que dirige el laboratorio de investigación experimental en hardware sofisticado y software para la producción autónoma, se une a Patrick Lin, filósofo y director del Grupo de Ética y Ciencias Emergentes de la Universidad Estatal Politécnica de California, para profundizar en la tecnología innovadora dentro del campo de la ética en estos automóviles.

Y es que los sistemas autónomos necesitan tomar decisiones en fracciones de segundo, lo que suscita desasosiegos deontológicos ya que como ejemplarizó Gerdes «es como si un niño sale de repente a la carretera y el automóvil tiene que elegir entre chocar contra el chaval o desviarse para colisionar contra una furgoneta que se acerca por el carril contrario».

Asimismo, el profesor va un paso más allá entrando en el dilema que surge entre proteger a los propios ocupantes o al chico. ¿Podríamos llegar a lesionar a los pasajeros si salvamos la vida del niño? Y es que como comenta Gerdes «no puedes coger el código ético y conectarlo a tu coche autónomo sin más».

Ante este panorama, los expertos están de acuerdo en que surge una importante conducta moral que desarrollar dentro de la conducción del futuro ya que el aparato autónomo no sabe a qué objeto o persona debe dar prioridad ante el riesgo inminente de sufrir una colisión.

A día de hoy, a los expertos filosóficos les invaden más preguntas que respuestas. ¿Deberían inspirarse en Asimov, cuya primera ley de la robótica dice que una máquina autónoma no puede causar daño a un ser humano, o debido a su inacción, permitir que le sea causado? El profesor y filósofo Lin declara que «no me gustaría que mi coche autónomo vendiese mi vida solo para salvar otras» aunque aclara que «esto no quiere decir que el vehículo deba preservar nuestra vida por encima de todo, sin que importe el número de víctimas implicadas en el siniestro».

“Cuando pides a un automóvil que tome una decisión, tienes un dilema ético”, explica Adriano Alessandrini, investigador de la Universidad La Sapienza de Roma. A lo que añade “puedes ver algo en tu camino, y puedes decidir cambiar de carril, y mientras lo haces, puedes encontrarte con que otra cosa está ocupando ese carril”.

Por su parte, Bryant Walker-Smith, profesor adjunto de la Universidad de Carolina del Sur, aclara que la toma de decisión ética se diseña ya durante el proceso de ingeniería automovilística. “La ética, la filosofía, la ley: todas estos asuntos sustentan numerosas decisiones”, declara.

Fabricantes comoFord, General Motors, Audi, Renault y Toyota se han acercado al Centro de Investigación en Automoción de la Universidad de Stanford para observar qué ocurre exactamente cuando el coche toma ciertas determinaciones morales. «Son conscientes de los problemas y los retos porque en la actualidad sus programadores tratan activamente de tomar esos juicios», afirma Chris Gerdes tras debatir la cuestión con Ford y General Motors.

Y es que «el camino a seguir es crear un principio absoluto según el cual las máquinas no tomen decisiones sobre la vida y la muerte», relata Wallach, investigador del Centro Interdisciplinar de Bioética de la Universidad de Yale. “Debe haber un ser humano involucrado. Si la gente piensa que no se la considerará responsable de las acciones que emprende, acabaremos teniendo una sociedad sin ley”, sentencia.

Mientras los filósofos siguen dando rienda suelta a sus pensamientos éticos, el profesor Gerdes aplica estas ideas en experimentos reales. En un circuito de carretera del norte de California probará, por ejemplo, cuándo es adecuado desobedecer las reglas de tráfico y cruzar una doble línea continua para dejar paso a ciclistas o a coches aparcados en doble fila.

Asimismo, Gerdes también está colaborando con Toyota para encontrar maneras para que un vehículo de estas características devuelva rápidamente el control a un conductor humano. Afirma además, que esta clase de medidas conllevan numerosos peligros a medida que las habilidades de conducción disminuyen. Y es que el problema de otorgar la potestad a un coche autónomo es que carece de empatía ya que «por ahora no se ha diseñado ningún sensor tan bueno como el ojo y el cerebro humano», finaliza el investigador.

«He de portarme siempre como si la norma de la conducta de mis actos hubiera de convertirse en ley universal», pensaba el filósofo prusiano Immanuel Kant. ¿Qué conducta deben seguir entonces los coches autónomos?, he ahí la cuestión.

Fuentes: MIT Technology Review, Iberciencia, Muycomputer